En este artículo se señala el riesgo de confiar demasiado en lo que parece una herramienta útil. Se subraya la complejidad emocional y ética de intervenir en el dolor humano desde un sistema que no siente, solo simula comprensión. Porque esto no va de saber usar la IA, sino de saber cuándo no usarla.

¡La tecnología se asoma al abismo del alma! Nadie lo habría imaginado hace unas décadas. Y, sin embargo, aquí estamos. Las máquinas aprenden. Y el sufrimiento humano deja huellas que los algoritmos empiezan a rastrear. Es una revolución. Y también un dilema moral.

Se habla. Se investiga. Se experimenta. Se desarrollan modelos que detectan el riesgo suicida a partir de textos, publicaciones, mensajes. Las palabras, que antes solo eran éter digital, ahora se analizan. Se examinan sus formas. Se extrae su esencia emocional. Y cuando una persona dice que no puede más… ya no solo lo escucha quien está cerca. Lo puede captar un sistema. Se ha visto que frases como «me quiero ir» o «ya no tiene sentido» están cargadas de patrones comunes. Patrón tras patrón, la máquina aprende. No lo hace por mágica intuición, porque no la tiene.

Por eso se afirma que el aprendizaje automático puede salvar vidas. Porque si se reconoce antes una señal, se puede actuar con antelación. Se han descrito ya plataformas donde esto ocurre. Algunos gigantes tecnológicos han implementado alertas internas. Si alguien publica un mensaje sospechoso, se activa un protocolo.

¿Hasta qué punto debe intervenir una máquina en la intimidad de quien está sufriendo?

Aquí empieza la segunda parte de esta historia. La parte donde el progreso tropieza con la ética.

Se dice que todo lo que ocurre en redes es público. Aunque eso se afirma, no siempre se siente así. Una frase escrita en medio de la desesperación puede acabar detectada por un algoritmo y eso puede salvar a alguien. O traspasar una línea que no hacía falta, es decir, el algoritmo, al detectar un patrón, puede generar una respuesta automática. Tal vez muestre un mensaje, y notifique a alguien, aunque eso parece que tiene buena intención, la persona puede sentirlo como una intromisión en algo que solo buscaba ser expresado, no interpretado ni gestionado, ya que no todo lo que suena a tristeza significa peligro real.

Se dan los falsos positivos. Se dan también los falsos negativos. Lo que significa que puede actuar sin necesidad. O dejar de actuar cuando más se necesita, que el silencio más desesperado pase desapercibido.

Por eso el verdadero desafío no está solo en perfeccionar los algoritmos, sino en comprender sus límites. Pueden calcular, clasificar, predecir. Pero no sienten. No comprenden el silencio detrás de un “estoy bien”. No interpretan matices emocionales, no responden con ternura ni con intuición. Ante el dolor humano profundo, siguen siendo herramientas. No acompañan. No contienen. No sanan. Solo procesan información. Y ni siquiera esa información es siempre fiable.

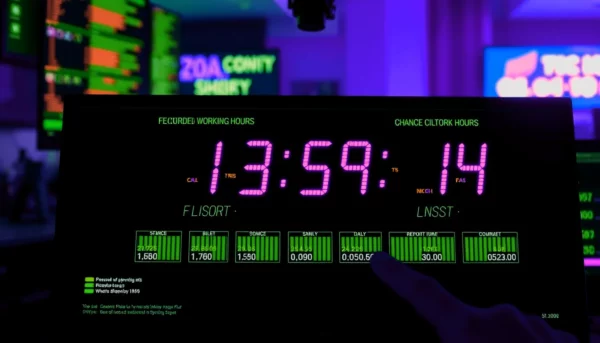

Modelos avanzados como ChatGPT o Bard pueden generar lo que se conoce como alucinaciones, es decir, afirmaciones incorrectas presentadas con total seguridad.

Según un estudio publicado en la revista JJMIR Mental Health, GPT-3.5 mostró un 39,6 % de alucinaciones y GPT-4 un 28,6 %, mientras que Bard (de Google) alcanzó hasta un 91,4 % en ciertos contextos clínicos. OpenAI también reconoce este fenómeno como uno de los retos actuales más complejos de resolver en sus propios informes técnicos. Incluso Nature ha advertido que “la confianza ciega en estos sistemas puede amplificar errores en contextos sensibles como la medicina, el derecho o la educación”. Por eso, ante cada respuesta brillante, debemos mantener activa una pregunta crítica: ¿eso es cierto?

Por eso no basta con tener un sistema que detecte patrones. Hace falta criterio. Supervisión. Y, sobre todo, humanidad.

Cuando alguien escribe una frase ambigua en una red social, el sistema puede reaccionar. Aunque no siempre lo hace. Puede que el mensaje pase desapercibido. Puede que active una alerta automática. Puede que no ocurra nada. Puede que ese mensaje lo lea un algoritmo. O puede que llegue a los ojos de quien de verdad puede entender. Y en ese caso, no hay sistema que decida. Solo queda la elección humana. La acción consciente. La intervención directa. De momento la IA puede hacer sonar una alarma, pero solo alguien con empatía, conocimiento y responsabilidad puede salvar a otra persona. Esa decisión no será código, será humana.

En otro artículo hablábamos de la alucinación. Ocurre cuando el modelo genera afirmaciones incorrectas o inventadas, aunque suenen creíbles. No es una mentira deliberada, ya que la IA no razona ni entiende, solo predice texto en función de patrones. Estas alucinaciones suelen aparecer cuando: El input es vago o ambiguo, se formulan prompts poco claros o mal enfocados, se superan los límites de tokens, o cuando no hay acceso a fuentes verificables.Aunque modelos como GPT-4 han mejorado, el riesgo sigue presente. Por eso, ante cualquier respuesta brillante, conviene mantener siempre activa esta duda saludable: ¿Esto es cierto? Ante ciertas palabras, lo que importa no es procesar datos, sino comprender silencios.

¿Qué puede aportar?

Ahora bien, también conviene reconocer lo que la inteligencia artificial puede aportar. Puede detectar señales en volúmenes gigantescos de datos, o reducir el tiempo de reacción ante un posible riesgo, o actuar como sistema de aviso temprano, como extensión técnica de un sistema humano de protección. Bien utilizada, con criterio y sin olvidar su rol secundario, puede ser una herramienta valiosa.

Este artículo continúa la reflexión iniciada en La paradoja de gritar en silencio. clic aquí.